La truffa del phishing vocale è cominciata con una serie di telefonate al manager da un numero ignoto ma in apparenza provenienti dall’amministratore delegato del Cavallino rampante, Benedetto Vigna. L’uso malevolo dell’AI si dimostra sempre più diffuso e pericoloso.

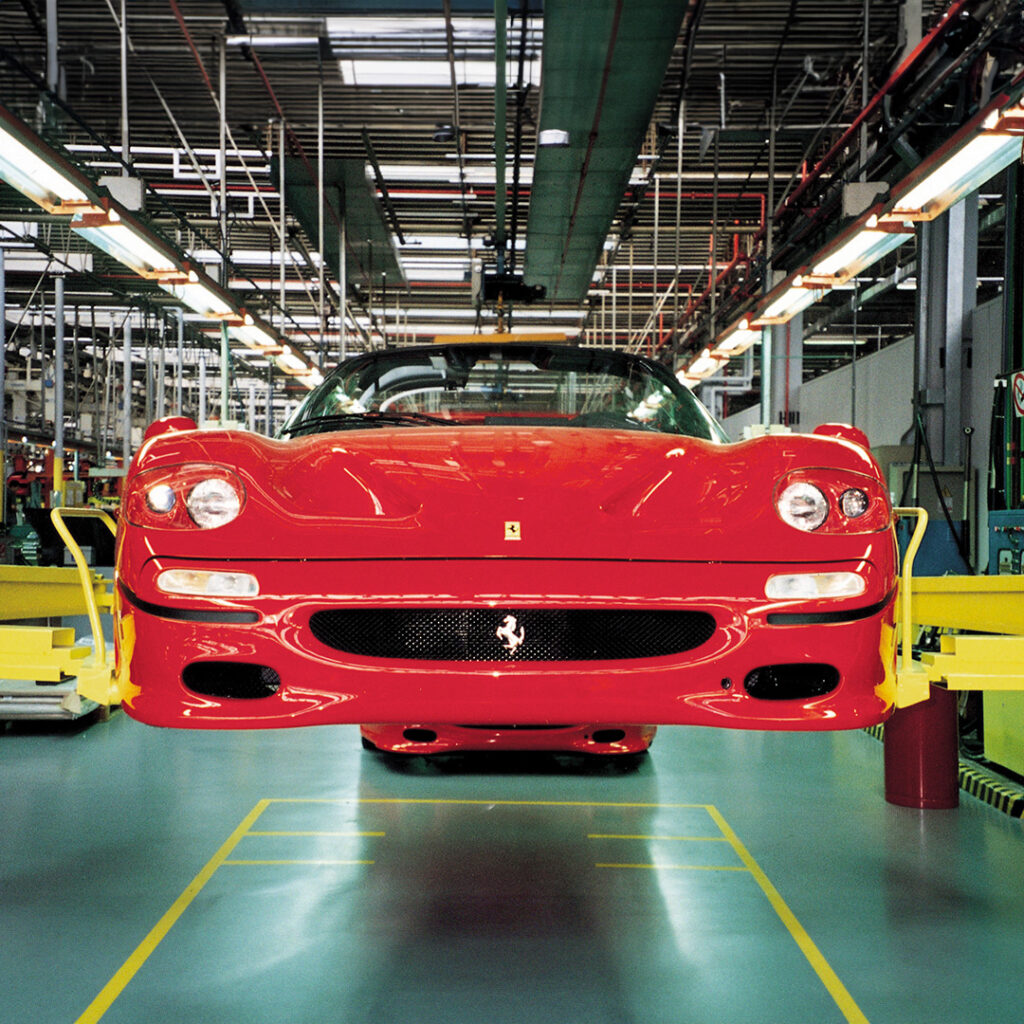

“Preparati stiamo per fare una grossa acquisizione e devi firmare alcuni documenti. Massima discrezione”. Deepfake del CEO di Ferrari tenta di truffare un manager con l’intelligenza artificiale. Quello citato è solo il primo di una serie di messaggi comunicati al telefono da una persona che aveva la stessa voce dell’amministratore delegato di Maranello, Benedetto Vigna. Un phishing vocale, insomma. Una trappola che non è “scattata”, in concreto, solo grade alla prontezza di spirito del manager – la cui identità non è stata resa nota – ma quanto accaduto, documentato dal Bloomberg, conferma ancora una volta i pericoli insiti nei deepfake.

La voce incriminata, con un leggero accento del Mezzogiorno, era del tutto simile a quella del ceo Vigna, originario di Pietrapertosa (Potenza), e nel corso della telefonata ha fatto riferimento sia a una rilevante acquisizione a stretto giro in Cina (“ehi, hai sentito della grande acquisizione che stiamo pianificando? Potrei aver bisogno del tuo aiuto”) sia all’urgenza di concludere alcune operazioni sul mercato valutario (“tenetevi pronti a firmare l’accordo di riservatezza che il nostro legale vi invierà il prima possibile: la Consob e la borsa di Milano sono già state informate. Tenetevi pronti e, per cortesia, discrezione massima”).

Contrastare le chiamate di vishing

Difendersi e valutare i contenuti falsi è possibile? Certo che sì. Ci sono infatti degli indizi per smascherare i deepfake, in modo tale da comprendere che l’identità dell’interlocutore non è autentica e si tratta, appunto, di un tentativo di vishing (o phishing vocale). Quest’ultimo, spiega il Garante Privacy sul proprio sito, “è una forma di truffa, sempre più diffusa, che utilizza il telefono come strumento per appropriarsi di dati personali – specie di natura bancaria o legati alle carte di credito – e sottrarre poi somme di denaro più o meno ingenti”.

Certo, esistono degli indizi per comprendere che l’identità dell’interlocutore non è autentica e si tratta di un tentativo di phishing vocale. Ad esempio, se la richiesta risulta particolarmente insolita. Ed è proprio ciò che ha fatto il manager della Ferrari che, nonostante l’accuratezza dell’imitazione, si è insospettito e ha posto una “domanda di sicurezza” al presunto Vigna, domandandogli quale libro – giorni addietro – gli aveva suggerito di leggere. Vistosi smascherato, il truffatore ha riattaccato subito e la scuderia di Maranello ha immediatamente intrapreso un’indagine interna.

Uso malevolo dell’intelligenza artificiale

Non è la prima volta che la Ferrari subisce tentativi malevoli che sfruttano le nuove tecnologie. Nel marzo del 2023, infatti, la Casa automobilistica italiana aveva comunicato di aver subito il furto di alcuni dati di contatto dei propri clienti (subito informati dell’accaduto) ed una richiesta di riscatto, immediatamente respinta. Quindi aveva avviato un’indagine su quanto accaduto in collaborazione con una società di cybersicurezza leader a livello mondiale, oltre ad informare le autorità competenti.

Detto del cyberattacco alla Ferrari, la truffa del phishing vocale ricorda il caso deepfake contro la multinazionale di design e ingegneria Arup, con sede centrale a Londra. Nonostante i forti sospetti su un’e-mail di phishing – dunque, non una telefonata fake – l’aspetto realistico e le voci dei suoi presunti colleghi avevano indotto un dipendente a procedere con le transazioni. A più ampio raggio, sul tema clonazione vocale e deepfake audio si è espresso Andrea Speziale, analista OSINT, che in un articolo su Cybersecurity Italia ha spiegato: “Gli audio (e soprattutto la clonazione vocale) rappresentano un aspetto meno noto ma che potenzialmente può produrre effetti anche più dannosi”.

English (US)

English (US)