Parliamo purtroppo solo ora della DockerCon svoltasi all’inizio di ottobre a Los Angeles e diciamo “purtroppo” perché il numero di novità interessanti presentate in merito alla tecnologia che ha rivoluzionato il modo di distribuire applicazioni nell’ultimo decennio è davvero consistente, ma come si dice… Meglio tardi che mai.

Il primo prodotto ad esser stato presentato è Docker Debug, nato con l’idea di risolvere i problemi relativi alle applicazioni che girano all’interno dei container. Non è sempre facile (e chi ha esperienza in questo senso lo può confermare) riconoscere con tempestività la causa dei malfunzionamenti, in particolare perché è raro trovare tutti i tool di cui si necessita all’interno del container stesso che non sta operando come dovrebbe. Da qui l’idea di Docker Debug:

What Docker Debug provides is an all-in-one tool set that is language independent. Developers can focus on problem-solving and not on setting up tooling for debugging.

Quello che Docker Debug fornisce è un completo set di tool indipendente dal linguaggio. Gli sviluppatori possono concentrarsi sulla risoluzione dei problemi, piuttosto che preparare l’ambiente di debug.È quello che afferma il CEO di Docker, Scott Johnston, nell’intervista a devclass.com.

Nella pratica Docker Debug è esso stesso un container completo di tutti i tool necessari al debug a cui viene aggiunto anche un aspetto di analisi intelligente di quelli che sono gli entrypoint ed i cmd, la validazione dell’architettura dei binari utilizzati ed un ambiente parallelo che mette insieme il container da analizzare e quello di debug, mediante un tool chiamato Nix.

I risultati, a detta del CEO, sono “magia” agli occhi dello sviluppatore.

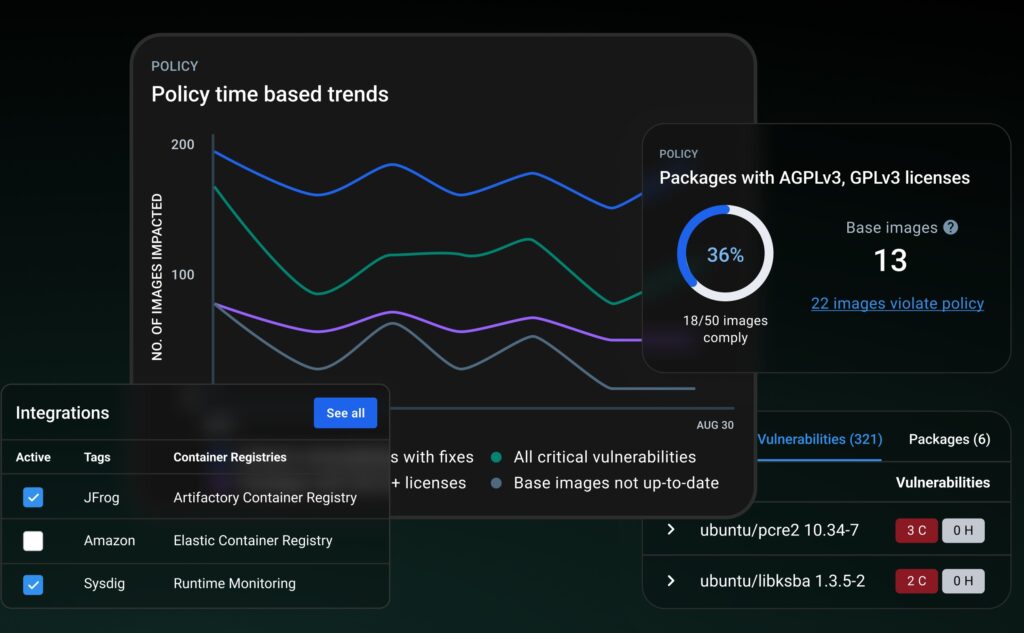

In parallelo all’annuncio di Docker Debug è stato presentato anche Docker Scout, un tool dedicato all’analisi di sicurezza dei container, attualmente in early access preview e di cui viene mostrato uno screenshot:

L’intento di questo tool è quello non di sostituire altri simili (come il Dependabot di GitHub), ma di lavorare in parallelo.

Infine ultimo, ma certamente non per importanza, è stato l’annuncio della nuova generazione di Docker Build, la quale è stata rivista nell’ottica di uno spostamento dalla sua natura “locale” ad una modalità remota che, a detta di Johnston, va ad incrementare fino a 39 volte la velocità di creazione delle immagini, il tutto grazie non solo a macchine più potenti rispetto al comune laptop degli sviluppatori, ma anche per via di nuovi meccanismi di caching che ne incrementano le funzionalità.

Insomma, l’azienda Docker pare essere più viva che mai, con i suoi 20 milioni di sviluppatori che ogni mese contribuiscono al suo sviluppo ed i suoi oltre 79 mila clienti. Paiono decisamente lontani i tempi della crisi, dopo l’acquisto da parte di Mirantis l’azienda si è messa decisamente sul piede giusto per proiettarsi verso il futuro.

Da sempre appassionato del mondo open-source e di Linux nel 2009 ho fondato il portale Mia Mamma Usa Linux! per condividere articoli, notizie ed in generale tutto quello che riguarda il mondo del pinguino, con particolare attenzione alle tematiche di interoperabilità, HA e cloud.

E, sì, mia mamma usa Linux dal 2009.

English (US)

English (US)